عملکرد سرورهای +A سوپرمیکرو با استفاده از پردازنده های نسل سوم AMD EPYC و ذخیره ساز Red Hat Ceph چگونه است؟

زیرساخت های ذخیره سازی سازمانی و فن آوری های مرتبط با آن هر ساله در حال پیشرفت هستند. به طور خاص، همانطور که فناوریهای IoT ،5G، هوش مصنوعی و یادگیری ماشین توجه روزافزونی را به خود جلب میکنند، تقاضا برای راهحلهای ذخیرهسازی تعریفشده نرمافزاری (Software-Defined Storage) مبتنی بر سرورهای ذخیرهسازی خوشهای نیز افزایش مییابد. پلتفرم ذخیره سازی Red Hat Ceph یک راه حل برجسته در SDS است که به اجرای کارآمد بارهای کاری با کارایی بالا کمک می کند. ویژگی های توان عملیاتی بالا و تاخیر کم دستگاه های ذخیره سازی مدرن، عوامل مهمی در بهبود عملکرد کلی یک خوشه Ceph هستند.

استفاده از خوشه Ceph با به کارگیری درایوهای حالت جامد (SSD) NVMe عملکرد کلی برنامه را به حداکثر میرساند.

کمپانی سوپرمیکرو خوشههای Ceph را بر اساس سرور ذخیره سازی Supermicro AS -2124US-TNRP مجهز به نسل سوم پردازندههای AMD EPYC و SSDهای all-flash NVMe طراحی کرده و سپس تست های مختلفی را برای طراحی و ارائه تنظیمات بهینه Ceph به کاربران Ceph انجام داده است.

قبل از پرداختن به جزئیات کامل و دقیق در رابطه با عملکرد سرورهای +A سوپرمیکرو به این سوال که چرا سرورهای کمپانی سوپرمیکرو را انتخاب کنیم؟ پاسخ میدهیم.

در پاسخ به این سوال باید گفت که کمپانی سوپرمیکرو یکی از مبتکران برجسته فناوری سرور و ذخیره ساز با کارایی بالا و ارائه دهنده اصلی سرور پیشرفته Building Block Solutions برای مراکز داده، رایانش ابری، هوش مصنوعی و سیستم های محاسبات لبه (edge) است. شرکت سوپرمیکرو متعهد به حفاظت از محیط زیست از طریق برنامه "We Keep IT Green" میباشد و کارآمدترین راه حل های سازگار با محیط زیست موجود در بازار را به مشتریان ارائه میدهد.

آشنایی با ذخیره ساز Red Hat Ceph

ذخیره ساز Red Hat Ceph یک پلتفرم ذخیرهساز منبع باز است که دادههای توزیع شده روی خوشه کامپیوتری را مدیریت میکند و رابطهایی برای ذخیره سازی در سطح شی، بلوک وفایل فراهم میکند. ذخیره ساز Red Hat Ceph در مقیاس وب، حفاظت از داده، قابلیت اطمینان و در دسترس بودن مورد نیاز را برای بارهای کاری ذخیره سازی شی ارائه میدهد. این راهحل برای بارهای کاری مدرن مانند هوش مصنوعی، زیرساختهای فضای ابری و تجزیه و تحلیل دادهها طراحی شده است. رابط های API (application programming interfaces) اجازه انتقال و ادغام برنامههای را میدهند. برخلاف ذخیره سازی سنتی، ذخیرهساز Red Hat Ceph برای دادهها با حجم بالا (معمولا پتابایت (PB) یا بزرگتر) بهینه شده است.

چگونگی راه اندازی سرورهای سوپرمیکرو

سوپرمیکرو چندین تست عملکرد را با تنظیمات زیر اجرا کرده است. شکل 1 معماری Supermicro را

- با سه گره مانیتورینگ

- چهار گره چهار گره OSD (Object Storage Daemon)

- 10 گره RBD (RADOS BLOCK Device)

نشان میهد.

شکل 1- راه اندازی تست پیکربندی Supermicro

جزئیات سخت افزار Supermicro و نرم افزار ذخیره ساز Red Hat Ceph

خوشههای ذخیرهساز Red Hat Ceph بر روی سرورهای +A سوپرمیکرو با پردازندههای نسل سوم AMD EPYC مستقر شدهاند. نسخه نرم افزار مورد استفاده ذخیره ساز Red Hat Ceph 4.2 ،Red Hat Enterprise Linux 8.2 وFlexible I/O Tester (fio) 3.25 میباشد.

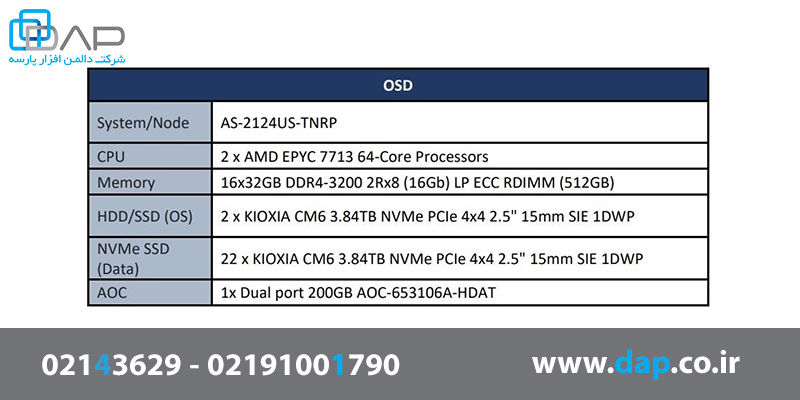

جدول 1- مشخصات گره های OSD

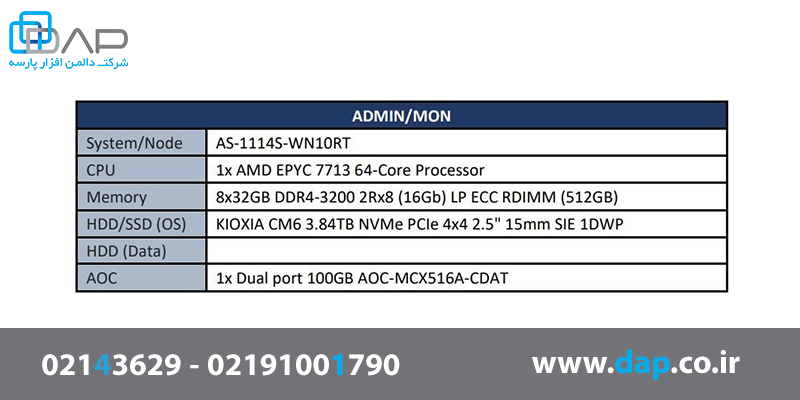

جدول 2- مشخصات گره های ADMIN

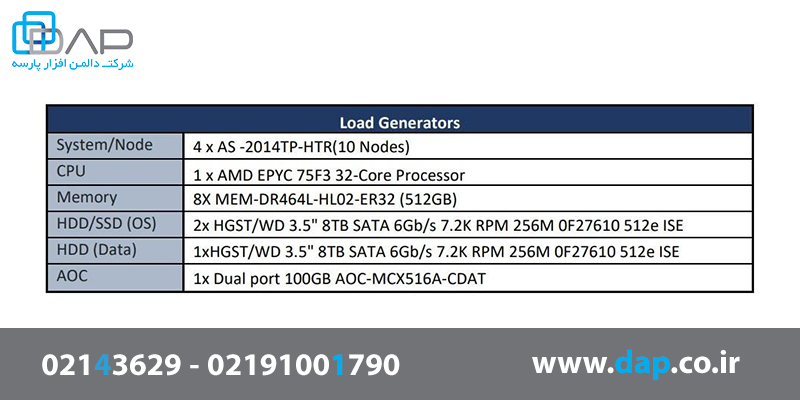

جدول 3- مشخصات Load Generators

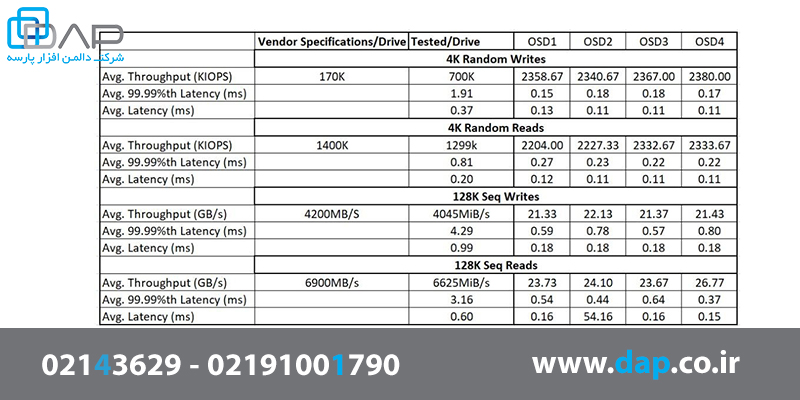

نتایج آزمون پایه

هدف از اولین آزمایش اندازه گیری عملکرد ورودی/خروجی خالص ذخیره سازی در هر گره بدون نصب بسته های Ceph است. هر گره دارای یک 22 KIOXIA CM6 3.84TB NVMe SSD است که عملکرد آن با استفاده از ابزار Fio (Flexible I/O Tester) با محرک libaio IO اندازه گیری شد.

عملکرد IOPS برای بارهای کاری تصادفی IO با اندازه IO کوچک (4 کیلوبایت) ارزیابی شد. عملکرد متوالی نیز برای بارهای کاری متوالی IO با اندازه IO بزرگ (128 کیلوبایت) ارزیابی شد. آزمایش سه بار انجام و نتایج به طور میانگین محاسبه شد. در زیر، نتایج آزمون پایه را نشان میدهیم:

- گزینههای Fio برای بار کاری تصادفی: تعداد کار - 8، عمق صف - 32، محرک IO - libaio

- گزینههای Fio برای بار کاری متوالی: تعداد کار - 1، عمق صف - 32، محرک libaio - IO

جدول 4- نتایج حاصل از آزمونهای پایه

تنظیمات و نتایج معیار

بخشهای زیر نتایج عملکرد معیار جامع برای یک کلاستر Ceph مبتنی بر all-flash را با استفاده از 22 KIOXIA HDS-SMP-KCD6XLUL3T84 NVMe SSD ارائه میدهند. این آزمایش در فضای ذخیره ساز مبتنی بر RBD که بلوک ذخیره ساز جزئی برای Ceph محسوب میشود، انجام شد. بارهای کاری با استفاده از معیار Fio با ده سرور کلاینت ایجاد شد. قبل از شروع آزمایش، ما 200 تصویر RBD ایجاد کردیم که در مجموع 20 ترابایت داده تولید میکند. سپس ما یک تکرار را 2 بار اعمال کردیم، در نتیجه اندازه کل دادههای ذخیره شده در کلاستر، 30 ترابایت شد.

- 10 Clients x 20 RBD images per client x 100 GB RBD image size = 20 TB (2x Replication: 15 TB x 2 = 30 TB)

جدول 5- مشخصات آزمونهای تصادفی و ترتیب

یک آزمون تصادفی با بارکاری 4 کیلوبایت IO کوچک و با تعداد کار معادل 8 و عمق صف 32 در هر نمونه Fio ایجاد و اجرا شد. همچنین یک آزمون پی در پی با بارکاری 128 کیلوبایت IO بزرگ با تعداد کار معادل 1 و عمق صف 32 در هر نمونه Fio ایجاد و اجرا شد. ما همچنین تغییرات تاخیر در هر آزمون را اندازهگیری کردیم. این آزمون سه بار انجام شد و میانگین نتایج به دست آمد.

- بارکاری نوشتن تصادفی 4 کیلوبایت

ما عملکرد و تأخیر نوشتن تصادفی 4 کیلوبایتی را با افزایش عمق صف روی 200 کلاینت اندازهگیری کردیم. در عمق صف 32، عملکرد نوشتن تصادفی 4 کیلوبایتی با میانگین K IOPS719، با تاخیر متوسط 8.9 میلی ثانیه و دنباله تاخیر متوسط (99.99٪ تاخیر هفتم) 134.23 میلی ثانیه اندازهگیری شد.

جدول 6- نتایج بارکاری نوشتن تصادفی 4 کیلوبایت روی 200 کلاینت

- بارکاری خواندن تصادفی 4 کیلوبایت

ما عملکرد و تأخیر خواندن تصادفی 4 کیلوبایتی را با افزایش عمق صف روی 200 کلاینت اندازهگیری کردیم. در عمق صف 32، عملکرد خواندن تصادفی 4 کیلوبایتی با میانگین 3194K IOPS، با تاخیر متوسط 2 میلی ثانیه و دنباله تاخیر (99.99٪ تاخیر هفتم) 683 میلی ثانیه، اندازه گیری شد. با افزایش عمق صف، عملکرد و تأخیر بیشتر میشود. نتایج حاصله نشان داد که دنباله تاخیر (99.99٪ تاخیر هفتم) در عمق صف 16 و عمق بالاتر به طور قابل توجهی افزایش یافت.

جدول 7- نتایج بارکاری خواندن تصادفی 4 کیلوبایت روی 200 کلاینت

- بار کاری نوشتن متوالی 128 کیلوبایت

با حداکثر تعداد 60 کلاینت میانگین خروجی بار کاری برای 128 کیلوبایت نوشتن متوالی، 16 گیگابایت در ثانیه است. تاخیرها با افزایش تعداد کلاینتها به طور پیوسته افزایش مییابد.

جدول 8- نتایج حاصل از بار کاری نوشتن متوالی 128 کیلوبایت

- بار کاری خواندن متوالی 128 کیلوبایت

با حداکثر تعداد 100 کلاینت میانگین خروجی بار کاری برای 128 کیلو بایت خواندن متوالی، 39 گیگابایت در ثانیه است. تاخیر با افزایش تعداد کلاینتها به طور پیوسته افزایش مییابد، در حالی که وقتی تعداد کلاینت به 100 رسید، توان عملیاتی نسبتا ثابت باقی میماند.

جدول 9- نتایج حاصل از بار کاری خواندن متوالی 128 کیلوبایت

خلاصه عملکرد ذخیره ساز Red Hat Ceph

• 4K Random Writes Latency @32 IO Depth 8.9ms

• 4K Random Writes throughput @32 IO Depth 719K IOPS

• 4K Random Reads Latency @32 IO Depth 2ms

• 4K Random Reads throughput @32 IO Depth 3.19M IOPS

• 128K Seq Writes throughput 16GB/s @60 clients

• 128K Seq Reads throughput 39GB/ s @200 clients

کلام آخر

کمپانی سوپرمیکرو یک مبتکر پیشرو در فناوریهای سرور و ذخیرهسازی با کارایی بالا و راندمان بالا و ارائهدهنده راهحلهای بلوک سازنده سرور پیشرفته برای مراکز داده سازمانی، محاسبات ابری، هوش مصنوعی و سیستمهای محاسبات لبه در سراسر جهان است.

سرورهای +A سوپرمیکرو برای محیط های سازمانی بهینه شدهاند و عملکرد بالایی را ارائه میدهند و آنها را به یک راه حل ایده آل برای راهحلهای ذخیرهسازی تعریفشده نرمافزاری مانند Red Hat Ceph تبدیل میکند. کمپانی سوپرمیکرو با استفاده از سرورهای AS -2124US-TNRP، پردازندههای نسل سوم AMD EPYC 7713 SSDهای NVMe همراه با نسل نسل چهارم رابط PCI-E و ذخیره ساز Red Hat Ceph، خوشه Ceph مبتنی بر all-flash را برای بهینه سازی عملکرد طراحی کرده است. این راه حل میتواند عملکرد خواندن تصادفی 4 کیلوبایتی را به بیش از 3.19 میلیون برساند و این یک عملکرد دائمی عالی میباشد. همچنین نسبت CPU سرور به درایو بهینه شده است تا حداکثر پهنای باند متعادل را در جدیدترین درایوهای U.2 و E1.S NVMe با سیستمهای Supermicro Ultra و BigTwin باز کند. پیکربندیهای مبتنی بر NVMe تمام فلش، فضای ذخیرهسازی بسیار، با کارایی بالا را با بالاترین IOPS در هر سیستم و هر گیگابایت ارائه میکنند و مجموعهای غنی از خدمات داده را در زیرساخت فناوری اطلاعات ممکن میسازند.

مترجم: محبوبه فغانی نرم

.w_188,h_155,r_k.png)